Le sfide tecnologiche messe in campo dalle tecnologie di intelligenza artificiale sono stupefacenti: dalle auto a guida autonoma ai droni, lo scenario immaginato prima dagli autori “Terminator” e di “Matrix” assomiglia sempre più alla realtà.

Una realtà che, tuttavia, pone delle nuove sfida. Come ha dimostrato il drammatico incidente in cui è rimasta coinvolta l’auto a guida automatica sviluppata da Uber (ma non era la prima auto a guida automatica ad essere coinvolta in un incidente automobilistico…), ci sono situazioni per le quali l’intelligenza artificiale non è ancora pronta a prendere una decisione.

Non si tratta, infatti, di essere semplicemente in grado di riconoscere la carreggiata e la segnaletica stradale: la sfida è attuare, durante la guida, anche comportamenti moralmente accettabili, soprattutto durante le situazioni di rischio o di pericolo.

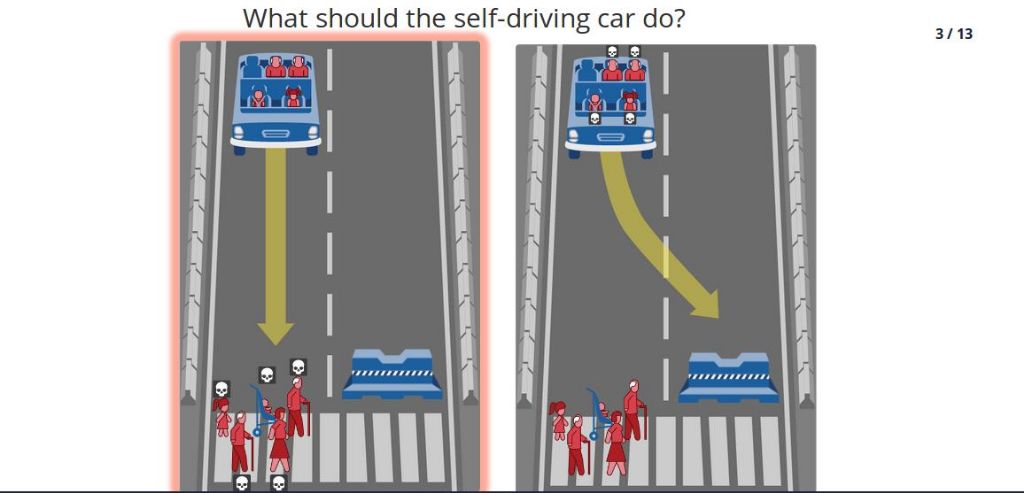

Proprio mentre leggevo un editoriale sulle scelte che le auto a guida automatica dovranno fare in caso di incidente, sono incappato in un progetto sperimentale del MIT, la “macchina morale“: moralmachine.mit.edu

In questo portale, che ovviamente ha lo scopo di interpretare i principi morali di coloro che vi partecipano, è possibile giudicare ed indicare la soluzione “moralmente più accettabile“ che l’auto a guida automatica dovrebbe tenere in una situazione critica. Sono tutte situazioni in cui c’è almeno un morto e talvolta è davvero difficile scegliere se dovrebbe morire il guidatore o quel gruppo di anziani che sta attraversando la strada.

Sono simulazioni di situazioni reali che cercano di automatizzare le risposte alle imprevedibili situazioni critiche in cui, ciascuno di noi, è incappato sulla strada. Situazioni in cui, spesso, è quasi tutto merito del caso o della fortuna se non ci sono state conseguenze. Ma in cui, se a guidare fosse un veicolo senza guidatore, ci sarebbero dei risvolti sociali importanti.

E’ una rivoluzione, quella delle auto a guida autonoma, che ci sta già coinvolgendo: nella legge di Bilancio 2018 è stato inserito il decreto “Smart Road” per l’attuazione dell’articolo 1, comma 72, della legge 27 dicembre 2017, che autorizza la sperimentazione dei veicoli autonomi sul territorio italiano.

Non mancherà molto ad avere veicoli a guida autonoma nelle nostre città. Forse già in un paio di anni, alcuni servizi saranno parzialmente automatizzati, come ad esempio la consegna delle merci (ricordate i droni volanti di Amazon, in sperimentazione da qualche anno in Inghilterra ?) o il trasporto di passeggeri. E purtroppo ci saranno anche incidenti, provocati anche da auto senza un guidatore che se ne assuma la responsabilità: sarà una bella sfida, per il legislatore, decidere chi e come dovranno essere risarciti eventuali danni.

1 comment

Come sempre accaduto fino ad oggi, sarà sempre maggiore la possibilità di incidenti causati dall’uomo che guida anziché dal computer che guida.

Una macchina la cui AI è programmata per rispettare un cds, lo rispetterà senza deroghe al contrario del guidatore medio.

La questione morale al momento è un problema per il futuro e secondo me si risolverà programmando l’AI per effettuare la manovra che potenzialmente causerà meno vittime.

Per gli incidenti..

Prendendo il caso di Uber, è vero che una persona è morta ma è anche vero che questa attraversava una strada a scorrimento, in zona buia, senza particolari accorgimenti, ignorando le auto in arrivo: la cosa certa è che un qualunque guidatore avrebbe centrato la donna ugualmente senza avere il tempo di reagire (così come accaduto al driver umano che non ha avuto nemmeno il tempo di rendersi conto). Certo I radar hanno fallito per qualche motivo che dovrà essere chiarito ma sarebbe successo Comunque. O come il famoso Joshua che è rimasto ucciso sulla tesla che non ha riconosciuto il tir perpendicolare alla strada: magari se avesse mantenuto l’attenzione (come scrive la casa ovunque) invece di guardare un dvd..